W Ingress grałem od początku października 2014 do początku stycznia 2015, czyli bity kwartał. Intensywność różna, choć najwyżej umiarkowana. Żadnych wielkich zrywów, maratonów itp. Ostatecznie osiągnąłem poziom 7 (i pół) z 16 aktualnie dostępnych w grze. Kiedyś było 8 poziomów. Wydaje mi się, że tyle wystarczy, by wyrobić sobie zdanie o produkcie.

Źródło: https://pl.wikipedia.org/wiki/Plik:Ingress_Logo_vector.svg

Czym jest Ingress?

Ingress – gra z gatunku MMO w systemie rzeczywistości rozszerzonej – tako rzecze Wikipedia w artykule nt. Ingress. I zasadniczo ma rację, bo nic dodać, nic ująć, ale własnymi słowami: gracze dzielą się na dwie drużyny (frakcje; Resistance i Enlightened) i działają za pośrednictwem urządzeń wyposażonych w GPS i dostęp do internetu (czytaj: smartfon) w wirtualnym świecie nałożonym na rzeczywisty. Działania graczy sprowadzają się do interakcji przy użyciu wirtualnego sprzętu z wirtualnymi portalami, umieszczonymi na interesujących bądź przynajmniej charakterystycznych elementach rzeczywistych (tablica, pomnik, most, grafitti, rzeźba itp.).

Gra jest tak skonstruowana, że nie ma konkretnego celu ani zakończenia. Ogólnie chodzi o to, żeby nasza frakcja zdobywała (w danym okresie/etapie) więcej punktów, niż frakcja przeciwna. Gracz poruszając się w świecie (rzeczywistym) zdobywa punkty akcji, które może wykorzystać do rozbudowy portali, linków (połączenia portali) lub pól (obszary ograniczone linkami) swojej frakcji lub niszczenia portali (linków, pól) frakcji przeciwnej. Jak widać, by móc działać wystarczy połazić po mieście, a przy odpowiednim balansie gra może trwać w nieskończoność. Sprytne.

Dodatkowo dochodzi element gamifikacji – poziomy, odznaki, osiągnięcia, statystyki, w tym także dotyczących działań w świecie realnym (np. ilość przebytych km w danym okresie czasu). Trzeba przyznać, że całość gry jest dobrze przemyślana i wciąga.

Jak grać w Ingress?

Kilka szybkich i ważnych porad dla początkujących, których nie znałem, gdy zaczynałem grać:

- odległość od portalu w momencie stawiania rezonatora ma znaczenie – im dalej, tym lepiej, bo trudniej zniszczyć taki portal,

- długość tworzonych linków nie ma znaczenia dla punktacji,

- wielkość tworzonych nie ma znaczenia dla punktacji.

Więcej porad znajdziesz na stronie Ingress Resistance Poznań.

Jak można to wykorzystać?

Poza najbardziej oczywistą rzeczą, czyli poligonem dla autorów aplikacji opartych na GPS (poprawa algorytmów, zarówno lokalizacji, jak i działania programu typu oszczędzanie baterii, poprawa map), czy badaniem poruszania się/zagęszczenia ludzi w danym rejonie, widzę dla Ingress parę innych zastosowań.

Przede wszystkim, skłonienie użytkownika do podawania dokładnej lokalizacji otwiera drogę do serwowania reklam. Dokładnych reklam, dotyczących sklepów/usług w zasięgu wzroku. Jeśli połączyć to z wiedzą, czego szukał użytkownik ostatnio w sieci (apteka, szewc, zegarmistrz, karta SD, fryzjer), to robi się interesująco. A teraz dodajmy do tego wiedzę, ile czasu i w jaki sposób poruszał się użytkownik oraz np. stan baterii i można zaproponować np. jedzenie albo picie w miejscu oferującym możliwość doładowania telefonu (OTOH dziwię się, że tak się fast foody itp. nie reklamują…). Przypuszczam, że tego typu reklamy miałyby szanse być bardzo skuteczne.

Kolejna możliwość, to dobrze znane z różnych gier promocje czy kupne bonusy i power-upy. Ale nie w formie płacenia prawdziwymi pieniędzmi za czysto wirtualne przedmioty, tylko skrzyżowania z reklamą. Co prawda chyba jeszcze nie jesteśmy systemowo przygotowani na coś takiego, ale wyobrażam to sobie w sposób podobny do powyższego – kupujesz pizzę w określonym lokalu, wklepujesz kod z paragonu (ew. korzystasz z wbudowanych płatności…) i dostajesz przedmioty w grze.

Czemu przestałem grać w Ingress?

Nie ukrywajmy, choć niby można grać „przy okazji”, to zabawa w Ingress zajmuje trochę czasu. Nawet, jeśli gra się wyłącznie przy okazji, w drodze, to jednak tu i tam się przystanie, tu zwolni, parę minut z życiorysu znika. Kolejna sprawa to czas pracy urządzenia na baterii. Gra po prostu wysysa energię z akumulatorów i oznaczała u mnie dodatkowe ładowanie w ciągu dnia. Transfer też znika dość szybko – mi na umiarkowane granie przy okazji schodziło ok. 1 GB danych miesięcznie.

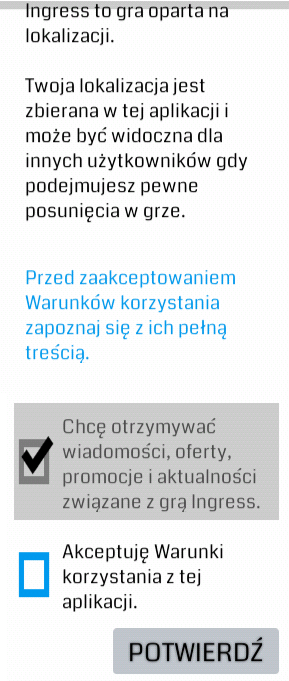

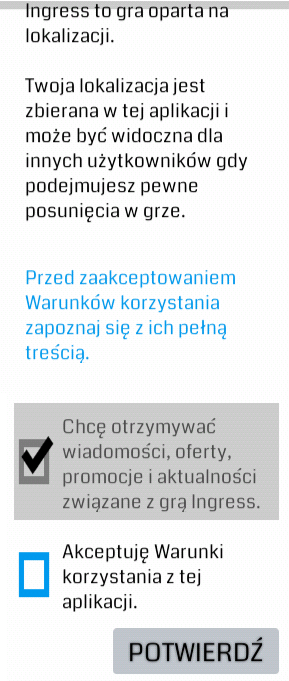

Gwoździem do trumny było jednak coś, co pojawiło się przy którejś aktualizacji: wymuszona zgoda na otrzymywanie powiadomień (zamieszczona poniżej). Czyżby przymiarka do opisanego wyżej sposobu wykorzystania? Nie wiem. Stwierdziłem, że enough is enough, przemyślałem za i przeciw i po prostu odinstalowałem grę.

Źródło: screenshot z aplikacji Ingress.

PS Wpis przeleżał blisko pół roku w szkicach, nie wszystkie informacje muszą być więc aktualne. Zdaję sobie sprawę, że grałem dość nietypowo, bo zupełnie bez aspektu socjalnego. Podobno ludzie spotykają się IRL w celu grania. Trochę zazdroszczę ilości wolnego czasu, ale fakt, Ingress może być fajnym pretekstem do wycieczek, spacerów, pozwala zwrócić uwagę na pewne aspekty rzeczywistości, które normalnie umykają itp. Z drugiej strony, jest to trochę chodzenie z nosem wlepionym w wyświetlacz, zamiast rozglądać się wokół.