W moim bąbelku zaczął Bobiko, ale o akcji dowiedziałem się z tego wpisu. Zastanawiałem się, czy brać w ogóle udział, bo w sumie na większość pytań już gdzieś kiedyś odpowiedziałem, ale niech tam! Do pytań!

Pytania są następujące:

- Dlaczego w ogóle zacząłeś blogować?

- Z jakiej platformy korzystasz do zarządzania swoim blogiem i dlaczego ją wybrałeś?

- Czy prowadziłeś już bloga na innych platformach?

- Jak piszesz swoje posty?

- Kiedy czujesz największą inspirację do pisania?

- Czy publikujesz natychmiast po napisaniu, czy też zostawiasz wersję roboczą jako wersję roboczą?

- Jaki jest Twój ulubiony post na Twoim blogu?

- Jakieś plany na przyszłość dotyczące Twojego bloga?

Dlaczego w ogóle zacząłeś blogować?

Nie pamiętam dokładnie. Z pierwszego wpisu widzę, że namówili mnie ludzie ze SzLUUG czyli Szczecin Linux Unix Users Group. Wiele osób tam miało wtedy blogi. Nie wiem czemu to miało dokładnie służyć. Wymianie wiedzy? Porządkowaniu jej? Tworzeniu społeczności?

Z jakiej platformy korzystasz do zarządzania swoim blogiem i dlaczego ją wybrałeś?

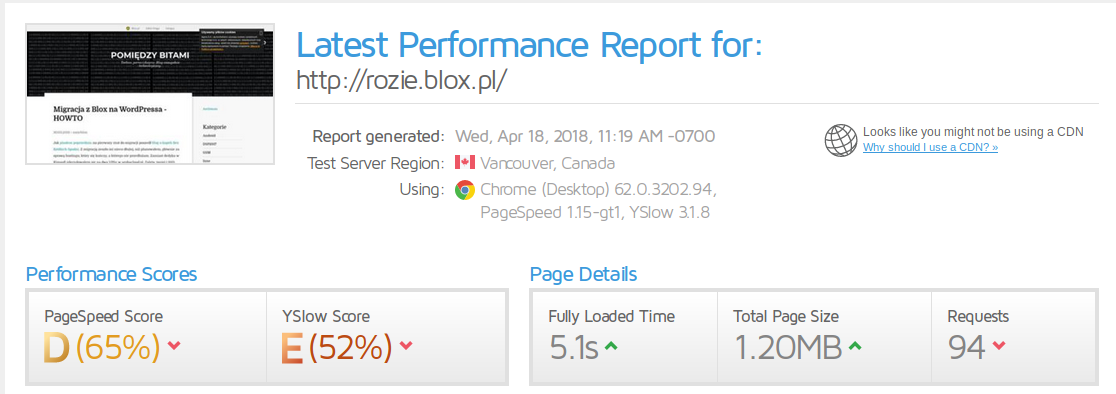

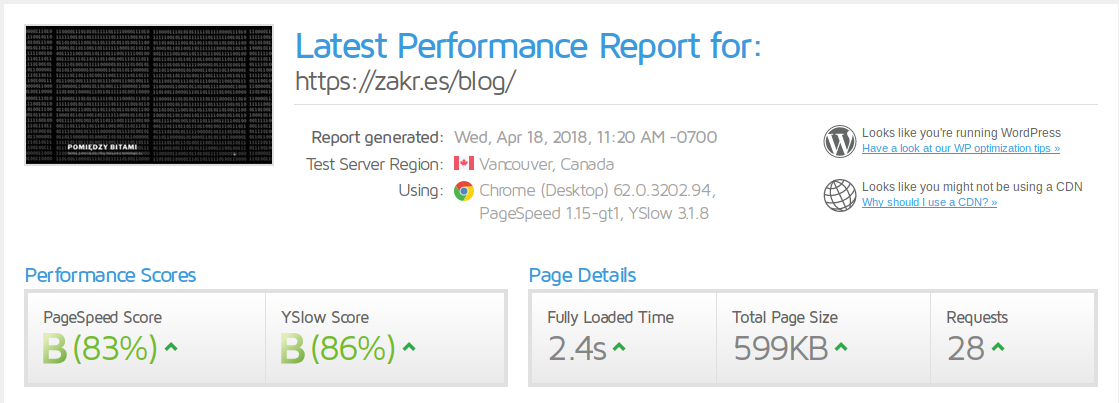

Aktualnie WordPress na własnym VPS. Czemu tak? Najtaniej, przy moich umiejętnościach i największa kontrola, bo żadna gotowa platforma, a zwłaszcza połączona z brakiem własnej domeny nie daje pełni własności treści/kontroli nad nią. Z drugiej strony WordPress jest bardzo popularny, dość dopracowany i pozwala na dynamiczne komentarze. Ale statyczne generatory bloga kuszą (od lat), tym bardziej, że w okolicach WordPressa nie dzieje się dobrze, ale to temat na inny wpis.

Czy prowadziłeś już bloga na innych platformach?

Tak. Pierwszy był Jogger.pl. Potem Blox.pl. Teraz jest WordPress. Jest pewna ciągłość, bo cała treść jest nadal dostępna online. Poza tym, na pobocznych projektach były/są jeszcze Pelican oraz Tumblr. O mikroblogach nawet nie wspominam.

Jak piszesz swoje posty?

Z tym było różnie, kiedyś często były zapisane jakieś myśli, fragmenty czy szkice w edytorze tekstu w terminalu i potem tworzyłem z tego wpis. Teraz coraz częściej piszę w edytorze WordPressa i albo publikuję od razu, albo zapisuję jako szkic. Zawsze jednak jest to komputer i klawiatura, żadnych smartfonów ani innych metod wprowadzania tekstu.

Kiedy czujesz największą inspirację do pisania?

Nie ma reguły.

Czy publikujesz natychmiast po napisaniu, czy też zostawiasz wersję roboczą jako wersję roboczą?

Zależy od wielu czynników. Od tego, ile mam czasu, od tego, czy chcę coś jeszcze dodatkowego znaleźć i umieścić wpisie, od tego, jak duży jest wpis. Procentowo nie liczyłem i nie mam pomysłu jak to szybko sprawdzić, ale stawiałbym okolice 50/50. O zalegających szkicach szykuje się wpis.

Jaki jest Twój ulubiony post na Twoim blogu?

Nie mam takiego. Zdarzało mi się wrócić po czasie do wielu z nich, z różnych powodów, i każdy z nich cieszył lub był przydatny.

Jakieś plany na przyszłość dotyczące Twojego bloga?

Brak planów. Cały czas chodzi mi po głowie przejście na statyczny generator, ale wiązałoby się to prawdopodobnie albo z wyłączeniem komentarzy, albo z kolejnym genialnym rozwiązaniem naklepanym na kolanie[1]. A ja lubię komentarze.

[1] Jestem prawie pewien, że aktualnie poszedłbym w stronę formularza, który wyśle maila, którego odbiorę, przeczytam i dodam (lub nie) jako komentarz. Tylko to już nie będzie statyczny blog, bo coś musi wysłać treść mailem… Skoro obecne rozwiązanie działa, a tamto spowoduje wiele problemów do rozwiązania, takich jak zabezpieczenia przed spamem to… nie widzę sensu.