Stało się, stało się, to co miało się stać

troszeczkę nieplanowo, noż…

Planowałem najpierw przenieść blog o BKS, poćwiczyć przepięcie ruchu i dopiero wziąć się za ten. Ponieważ z czasem i motywacją było słabo, parę wpisów chodziło mi po głowie, a pisać nie było gdzie, poszedłem na łatwiznę. Stwierdziłem, że albo przeniosę teraz i dopieszczę później, albo nigdy tego nie zrobię. Zatem blog został zamrożony i przeniesiony w nowe miejsce dla Pomiędzy Bitami.

Poszedłem na łatwiznę i przeniosłem się z Blox na WordPressa. Jednak. Z rzeczy związanych z migracją – na razie zmieniłem licencję, za moment pojawi się info we wpisach skąd pochodzą. W najbliższym czasie zmienię źródło feeda RSS (jeśli ktoś czyta via RSS i nie korzysta jeszcze z RSS w wersji opartej o Feedburner, to polecam przepięcie się) i linki z ważniejszych miejsc.

TBH rozważałem mirror statyczny i zaczęcie pisania od nowa, po prostu, ale ostatecznie wykonałem eksport. Wpisy są wszystkie, komentarze być może nie, stron nie ma, bo ani nie mam na to skryptu, ani nie chcę przenosić wszystkiego – przydadzą się tam gruntowne porządki, zresztą to proste copy & paste…

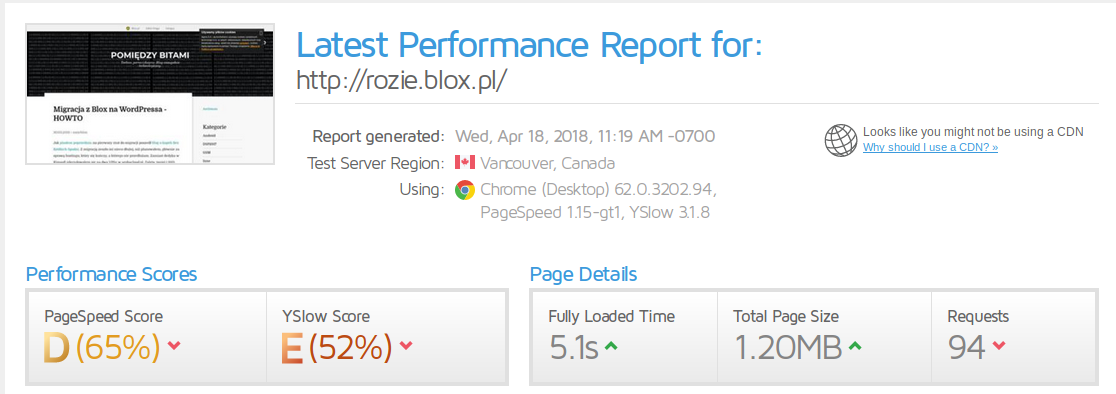

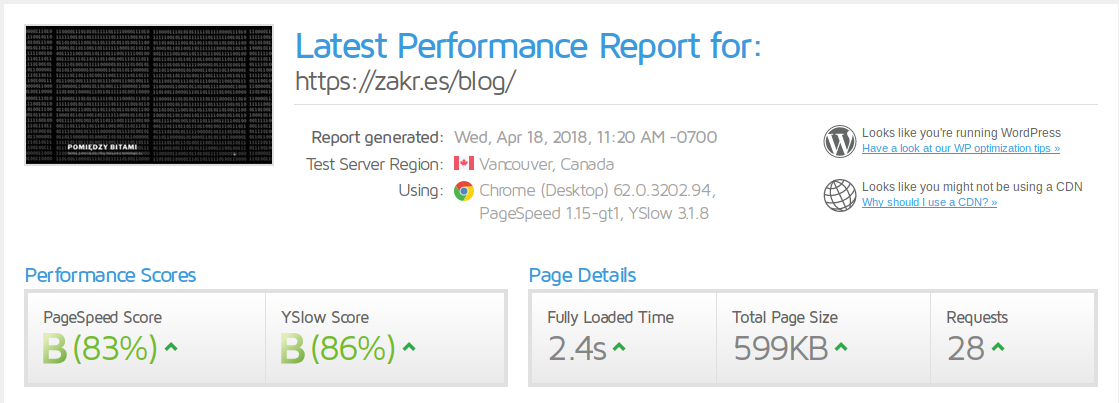

Stoi to wszystko na niezbyt fortunnej lokalizacji, bo arubacloud w czeskim DC szybkością sieci nie grzeszy, ale i tak jest sporo lżej i szybciej, niż na Blox, mimo możliwie tych samych ustawień.

OK, dla jasności, tu są jakieś drobiazgi, których nie ma (przynajmniej na razie) w nowym miejscu, typu LinkWithin itp. ale nie robią one takiej różnicy. No i gdyby było więcej grafik, to wynik wyglądałby gorzej, ale to już kwestia wspomnianej sieci w czeskim DC.

Oczywiście wszystko lata bezpiecznie i wydajnie po SSL i HTTP/2 i mam możliwość pełnej kontroli nad tym, co się dzieje.

Blox pożegnał mnie w stylu, w jakim go zapamiętam – wyłączyłem możliwość komentowania na blogach, zapisałem ustawienia i co? Po napisaniu tego wpisu, czyli kilkanaście minut później, nadal mogłem dodać testowy komentarz.

(Not so) fun fact: uciekłem z Joggera z powodu cenzury i autorytaryzmu administratorów. Doczekałem się cenzury i autorytaryzmu ze strony Agory (ale o tym to już w nowym miejscu więcej napiszę).

UPDATE: Wygląda na to, że ustawienie dot. komentarzy działa wyłącznie dla nowych wpisów, w starych nie ma możliwości wyłączenia możliwości komentowania (pewnie można uprzykrzać życie przy pomocy zepsutej CAPTCHA i moderowania, zamierzam, ale później, może się coś jeszcze przeładuje). Wot usability!