Co jakiś czas dobiegają mnie, zarówno na FB, jak i od znajomych w pracy informacje o kolejnych „przełomach”. A to miazga w debacie, a to sufler, a to coś. I z utęsknieniem czekam, aż się to wszystko skończy. Nawet wiem, jak się skończy, ale o tym za chwilę.

Nie żebym się zupełnie wyborami nie interesował. Nawet dopisałem się do komisji wyborczej, czyli głosować pójdę. Ale żeby się tak podniecać? IMO nie ma sensu. Mieliśmy prezydenta z PiS, nic nie wybuchło (choć niektórzy twierdzą, że trotyl). Zresztą, prezydent to głównie funkcja reprezentacyjna. Ale jest jeszcze inny aspekt.

PO i PiS, wbrew temu, jak się je kreuje w mediach podkreślając różnice, to partie w praktyce dość podobne. Oczywiście w obietnicach przedwyborczych zawsze wielkie zmiany i złote góry, ale… kto pamięta zapowiedź likwidacji obowiązku meldunkowego? Się nie dało. Religia w szkole (zamiast w kościołach!) jest? Jest. Aborcja, legalizacja narkotyków – bez zmian. Znaczy: wybory prezydenckie wygra PO-PiS. I przez kolejne 5 lat nic się – przynajmniej w zakresie prezydenta – nie zmieni. Bo w ostatnich latach poglądy partii (w UK, u nas pewnie podobnie; wszystkich partii) przesunęły się mocno w prawo i w stronę autorytaryzmu.

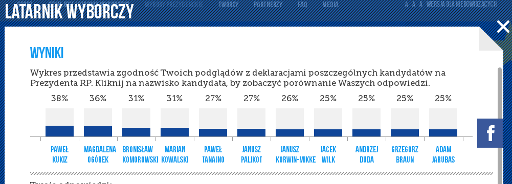

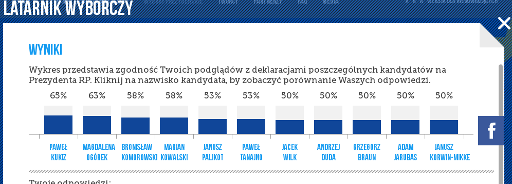

Jakby ktoś dorwał listę oficjalnych poglądów politycznych partii/kandydatów, to jest dobra strona z mapą polityczną. I można sprawdzić swoje poglądy, przy okazji. No i jakby były „oficjalne” partyjne, to w sumie lepsze, niż to, co proponował Latarnik Wyborczy. Mi się nie chce, szczególnie, że do poprawionego algorytmu Latarnika Wyborczego zajrzało raptem kilkanaście osób (a tak ładnie się zapowiadało po krytyce…). I w ogóle polecam ten wpis.

Nie, żeby w ogóle się nic nie działo, bo jakieś drobne zmiany są. Np. inicjatywa, którą rozkręcił przy okazji wyborów prezydenckich VaGla dot. publikacji umów cywilnoprawnych przez partie. No ale to jakby obok, przy okazji i jednak pozostaje póki co (i niestety stawiam, że tak zostanie, za duża stawka…) niszowym bólem w tylnej części ciała obu partii.

UPDATE Przypomniało mi się, że mam kawałek idealnie pasujący na tę okoliczność.