Pierwotnie ten wpis miał być komentarzem do wpisu o agonii blogów, jednak z racji rozmiaru i uporządkowania ew. dyskusji stwierdziłem, że bardziej pasuje jako samodzielny wpis.

Zamykanie kolejnych polskich platform blogowych nie jest koniec blogosfery. To zaledwie koniec platform blogowych jako takich. IMO je spotyka los podobny do shared hostingu, odkąd pojawiły się VPSy. Platformy tracą sens, bo:

- i własny hosting, i domeny drastycznie potaniały,

- platformy nakładają ograniczenia i/lub kosztują relatywnie dużo,

- pojawiły się międzyplatformowe narzędzia do dzielenia się komentarzami dot. wpisów na blogach – FB, Disqus, itp.

Tego wszystkiego kiedyś nie było. Porównując z telefonami – nadal z nich korzystamy, ale kto ostatnio korzystał z telefonu stacjonarnego (i w dodatku nie VoIP), o budkach telefonicznych nie wspominając?

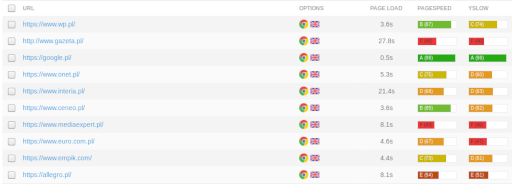

Wiele blogów ma się jednak dobrze. Niektóre mają się wręcz świetnie. Z polskiego podwórka na myśl przychodzą mi tu – tak od ręki zaufanatrzeciastrona.pl, sekurak.pl, niebezpiecznik.pl, majsterkowo.pl, jakoszczedzacpieniadze.pl czy subiektywnieofinansach.pl. Od strony technicznej te portale(?) to są blogi. I myślę, że zasięgiem biją na głowę najlepsze blogi sprzed lat dziesięciu lub więcej. A może i całe platformy…

Prawdą jest, że bariera wejścia w blogowanie wzrosła, jeśli porównać ją z innymi formami komunikacji, ale tak naprawdę jest łatwiej, niż kiedyś. Narzędzia są bardziej dopracowane, takiego WordPressa można postawić z tutoriala z wiedzą nie większą, niż potrzebna kiedyś do modyfikacji szablonu. To samo zjawisko dotyczy innych rodzajów twórczości – amatorskie zespoły muzyczne mają często dziś do dyspozycji rozwiązania, które kiedyś były dostępne wyłącznie profesjonalistom. Bardziej mam tu na myśli obróbkę dźwięku, niż instrumenty. Łatwiej jest stworzyć zdatną do wydania muzykę i ją wydać, niż kiedyś.

Zgadzam się, że konkurencja innych platform powoduje, że może nie być sensu pisać własnego bloga lub trudniej będzie się wybić. Jeśli nie będzie dobry, to nie będzie czytany, bo przegra konkurencję z innymi formami. To trochę jak z filmami – spróbujcie dziś obejrzeć jakieś arcydzieło sprzed 60 lub więcej lat. Albo serial sprzed 30-40 lat. To nie są złe filmy! Ale w bezpośrednim starciu ze współczesnymi, czy nawet nowszymi produkcjami na większą skalę nie mają szans. Treści do konsumpcji jest coraz więcej, doba ma nadal 24h, długość życia aż tak nie wzrosła. Trzeba wybierać, a warunki selekcji są coraz ostrzejsze.

Zresztą blogi same wspomagały Facebooka w dominacji rynku. Wielu blogerów założyło fanpage bloga, licząc na promocję, ale tak naprawdę dostarczali tylko dodatkowej treści FB i powodowali, że zaglądanie gdzie indziej miało jeszcze mniej sensu. Zresztą miałem o tym notkę – Facebook przejął rolę wielu serwisów, nie tylko blogów.

Nie upatrywałbym problemu blogosfery w próbach monetyzacji. Tak, też widziałem blogi, które poszły w komercję i straciły przy tym cały urok, ale – patrząc z perspektywy – wygląda mi to bardziej na odcinanie kuponów od czegoś, co było fajne, ale do czego straciło się serce i można albo zakończyć, albo zarobić przy okazji parę złotych. Sam bawiłem się w różne formy zarabiania na blogu, a nawet miałem o tym notkę. IMO nie dało się na blogu bezpośrednio zarabiać. Nawet biorąc poprawkę na specyficzną tematykę i potencjalnie większą niechęć odbiorców do wyświetlanych reklam uważam, że to wszystko na orzeszki. Mi nie udało się nigdy osiągnąć z reklam itp. form osiągnąć pułapu pozwalającego na opłacenie abonamentu za dostęp do internetu. Takie sobie kiedyś kryterium sukcesu wybrałem. 😉 Więc nawet rząd wielkości większe dochody to są orzeszki, jeśli mówimy o pracy na jakąś nieułamkową część etatu.

Podkreślam jednak – chodzi o zarobek bezpośredni. Jak zerkniecie na blogi z jednego z pierwszych akapitów, to jak najbardziej pomagają one autorom zarabiać pieniądze. Ale nie na samych blogach. Mądrze na to mówią budowa marki. W praktyce chodzi o jakąś tam rozpoznawalność.

Jeśli mnie ktoś zapyta, czy warto pisać bloga, bez wahania odpowiem, że tak, ale wyłącznie na własnej platformie i z własną domeną. W przeciwieństwie do dowolnej platformy współdzielonej to jedyna powszechnie dostępna forma publikacji, nad którą mamy pełną kontrolę i która daje pełną niezależność. Możemy – i inni ludzie – łatwo wyszukać stare wpisy, podlinkować do nich i… ktoś to przeczyta (spróbujcie tego na FB…). Możemy bez problemu przenieść się z całą zawartością w inne miejsce i właściciel platformy nie będzie nam dyktował, czy możemy to zrobić, w jakiej formie, zakresie i kiedy. FB jest równie wieczny, jak nk.pl. 😉

A zabawa z bebechami okołoblogowymi jest IMO podobną okazją do nauki, jak niegdyś zabawa z tworzeniem szablonów blogów.